1 引 言

第七次全国人口普查显示我国城镇化率目前已超过60%[1]。相应地,我国大城市陆续进入存量甚至减量发展阶段,城市发展的首要任务也从空间增长和生产效率提升转换到城市有机更新与精细化管理[2]。城市建筑作为城市更新的基本空间单元,基于此所获取的建筑密度、建筑高度、容积率等指标也是城市有机更新与精细化管理研究的重要特征,如老城区的建筑高度及城市天际线控制引导等研究工作[3]以及建筑轮廓数据在城市精细化管理、城市重点地区设计中的重要作用[4-5]。当前建筑轮廓数据主要来源于人机交互解译或高精度的测绘数据,其耗时耗力、成本高及更新频率低等问题对开展深入广泛的研究造成了困扰[6]。因此,从遥感影像中快速、准确、实时地获取建筑物轮廓信息,对城市规划及精细化管理有着重要意义。

当前用于建筑物轮廓提取的深度学习方法主要有语义分割模型和实例分割模型两大类。语义分割模型是为图像中的每个像素分配标签的过程,使具有相同标签的像素就某种视觉或语义属性相互连接[15]。作为分割精度和分割效率两个方面都表现良好的算法,语义分割模型被广泛应用于遥感影像提取建筑物轮廓中。很多学者通过雷达数据和高分影像等数据源的融合[16-17],深度学习模型的接受域和池化操作调整[18]、低层特征融合[19]、不同网络结构及注意力机制和高斯金字塔的修改等网络结构[20-23]的改进,增加融合策略[24]、全连接条件随机场[25-26]等分割结果的后处理,在不同程度上提升了建筑物轮廓提取的效率和表现。此外,语义分割网络结合二值与浮点数混用可以解决全局网络精度差、训练慢的问题,为建筑物轮廓的实时检测提供了条件[27]。

当前,通过高分遥感影像开展建筑轮廓提取的深度学习网络主要为单一改进语义分割模型或实例分割模型。但是,鲜有研究对比两类深度学习模型在建筑物轮廓提取的表现性及敏感性;两类模型的精度比较也需要从建筑功能、建筑布局等角度开展更为详细的研究。针对上述问题,本研究以北京市全域建筑空间为研究对象,选用经典的语义分割模型U-Net、DANet及其改进模型UA-Net(U Attention Net)和不同的骨干网络的实例分割模型Mask R-CNN、Mask R-CNN FPN及Mask R-CNN RX FPN分别进行高分影像的建筑轮廓提取测试,对语义分割及实例分割模型在建筑轮廓提取任务的精度及效果进行对比,分析两种模型对于不同类型的建筑识别效果的优劣性,并选择最优模型对北京市域建筑空间进行了提取。

2 研究区与数据

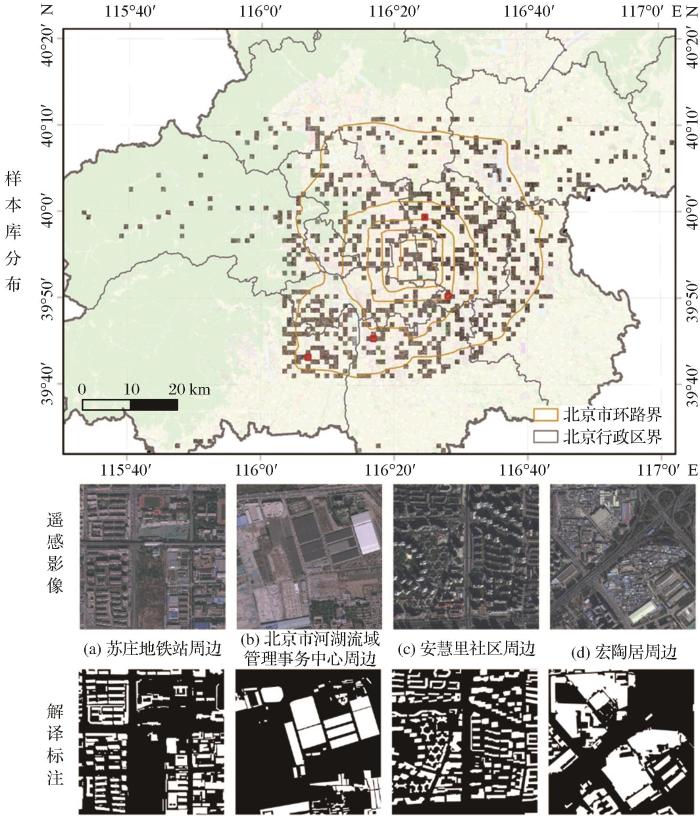

作为我国的首都和直辖市,北京市行政区面积达16 410 km2,位于华北平原北部(115.7°~117.4° E,39.4°~41.6° N),与天津市接壤,环绕于河北省之中。

本研究以2018年为基准年,建立北京市典型区域建筑类样本库。训练样本是多种监督学习(如机器学习、深度学习)算法的重要数据基础,训练样本的质量与数量会对分类精度产生直接影响。本研究选用北京二号高分辨率影像数据,通过数据融合的方式,得到包含3个波段信息(红、绿、蓝波段)的高分辨率影像(0.8 m)。为便于样本库的建立和模型全域推广,研究对高分辨率遥感数据进行1 km×1 km切片处理,并从中随机挑选839张样本影像(约为全域面积的5%)进行建筑轮廓标记。这些建筑样本既有位于山区也有分布于平原区的建成区,包括了高层及低层建筑(图1),保证了样本随机性和多样性。研究通过人机交互的方式对样本的建筑轮廓进行解译,构建北京市高分影像建筑样本库。通过旋转、镜像等图像几何变换操作对样本数据进行扩充,为后续多种深度学习模型的比较提供丰富的训练基础。

图1

图1

样本库分布及遥感影像与解译样本(包括中高层建筑和平房区等)

Fig.1

Sample database distribution and examples of remote sensing imagery and interpretation samples

3 研究方法

研究基于深度学习提取高分遥感影像建筑轮廓的方法对比的技术路线如图2所示。首先,基于高分遥感影像进行北京市的建筑轮廓样本制备;其次,不同深度学习模型训练调优,利用典型深度学习语义分割,如编码解码结构的U-Net、自注意力机制的DANet、结合自注意力机制和编码解码结构的UA-Net,以及实例分割模型如Mask R-CNN、增加信息特征金字塔Mask R-CNN FPN、替换骨干网络的Mask R-CNN RX FPN等两个类别的多种模型开展迭代训练调优;最后,从多个角度对以上模型提取建筑的精度进行对比评价,并选取提取结果表现最好的模型开展北京市的建筑轮廓识别。

图2

图2

深度学习提取建筑轮廓方法对比技术路线

Fig.2

The flow chart of Comparison of deep learning methods for extracting building footprints

3.1 语义分割模型

U-Net网络最早用于生物和医学影像的分割,是一种经典的语义分割算法,近年来在目标分类方面得到了广泛应用。U-Net网络结构主要由卷积层、最大池化层(下采样)、反卷积层(上采样)以及ReLU(Rectified Linear Unit,修正线性单元)非线性激活函数组成,为典型的编码器-解码器U型结构。U-Net网络具有利用少量样本数据训练学习的能力以及轻量化的网络模型方便对其进行改进。

Dual Attention Network(DANet)利用自注意力机制进行丰富语义信息的捕获,在带有空洞卷积的FCN架构的尾部添加两个并行的注意力机制:空间注意力机制和通道注意力机制。并且注意力机制模块为独立模块,可以直接插入到已有的FCN中,不会增加太多参数,有效地增强特征表示。

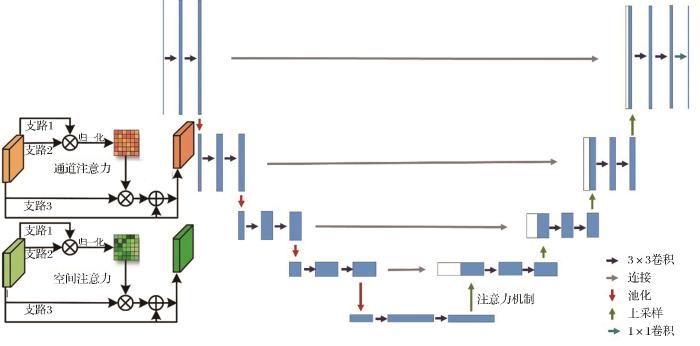

基于U-Net编码器—解码器及DANet注意力机制的特点,本研究设计了U-Attention Net(UA-Net)网络结构(如图3)。该网络主要分为3个部分,左侧为5层卷积层,右侧对应5层上采样,在两者连接中添加了注意力机制。左侧的卷积层进行提取和学习图像特征,右侧的上采样层与左侧对应,用于还原至原图像大小,在上采样的同时会连接对应卷积层的特征图,得到更高层次的特征组合,从而提高模型的结果精确度。注意力机制中包含了空间注意力和通道注意力机制。空间注意力机制是任意空间位置特征的更新,即通过图像所有空间位置上特征的加权聚合进行更新,权重由两个空间位置上的特征相似性决定,特征相似则权重更高,不需要考虑两个空间位置的距离;通道注意力机制中应用了相似的自注意力机制来学习任意两个通道映射之间的关系,通过所有通道的加权聚合来更新某个通道。

图3

3.2 实例分割模型

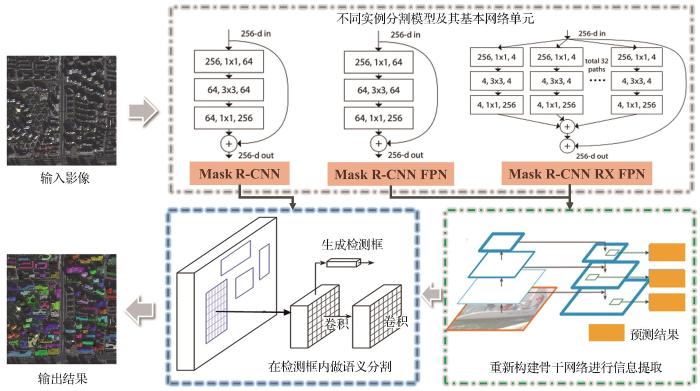

Mask R-CNN[36]是一种灵活的实例分割框架,可以对骨干网络进行修改替换以及增加不同的分支完成不同的任务,包括了骨干网络、ROI Align层和全卷积网络层。

初始的Mask R-CNN模型以深度残差网络[37](ResNet)为骨干网络,骨干网络ResNeXt结构块[38]借鉴了ResNet中的恒等映射与残差学习的思路,将残差学习部分单路卷积变成了多个支路的多路卷积,多路径分组卷积遵循分割、转换合并范式,各个分支同构使用相同的拓扑结构。ResNeXt作为最强骨干网络之一,可以在不增加参数复杂度的前提下提高准确率。考虑到遥感影像中建筑物轮廓的特征复杂,图像金字塔的思想可以解决物体监测场景中小尺寸物体监测困难的问题,因此研究将特征金字塔网络(Feature Pyramid Networks,FPN)[39]引入到模型中,FPN采用自底向上、自顶向下以及横向连接的方式将浅、中层次特征图等不同等级特征图结合在一起,可在提升模型精度的同时,对其训练的时间复杂度增加很少。

Mask R-CNN由Faster R-CNN[40]拓展而来,在每个ROI(Region of Interest)增加一个预测分割掩码的全卷积网络层,进而在生成检测框的同时,实现目标掩膜预测。ROI Pooling是从每个ROI提取特征图的标准操作,采用取整的方法将ROI量化到和特征图相匹配的粒度。量化操作对像素级的语义分割过程有着较大影响,改进之后提出的ROI Align层,采用双线性插值的方法获取每个位置的精确值,消除了粗糙量化操作带来的误差,同时保证提取特征与像素精准对齐。

全卷积网络产生对应的掩膜预测分支。其中分类预测分支对ROI给出预测,产生对应的矩形框的输出边界;基于输出边界,掩膜预测分支产生二值掩码。Mask R-CNN对于每个分类输出边界均独立地对应掩膜预结果,有效的避免了类间的竞争,提升了模型的性能。本研究选取经典实例分割模型Mask R-CNN(以ResNet为骨干网络),并在其网络结构基础上,分别以残差网络ResNet、ResNeXt结合FPN作为骨干网络衍生出另外两个模型Mask R-CNN FPN(以ResNet和FPN为骨干网络)和Mask R-CNN RX FPN(以ResNeXt和FPN为骨干网络),如图4,测试以上3个实例分割模型对于高分影像提取建筑轮廓的精度与效果。

图4

3.3 模型评价方法

本研究使用4个指标评价模型,分别为精确率(precision)、召回率(recall)、F1指数(F1)以及重叠度(Intersection over Union,IoU),从多个角度对建筑轮廓划分效果进行定量评估。其中,精确率、召回率、F1指数的定义如下:

其中:TP表示实际为正例且被模型划分为正例的像素数;FP表示实际为负例但被模型划分为正例的像素数;FN表示实际为正例但被模型划分为负例的像素数。在本研究中,建筑物轮廓的像素为正例,背景像素为负例。

重叠度IoU的定义为:

其中,

3.4 实验环境及模型测试

为保证实验对比的有效性,研究在统一的硬件及软件环境下选择典型的3种语义分割和3种实例分割模型进行方法对比。软件环境使用开源的PyTorch学习框架,使用Python语言编程实现语义分割、实例分割算法网络,硬件环境为惠普服务器,配备有TU102 [TITAN RTX]显卡(24 G)、64位Ubuntu 18.04操作系统。随机选取样本库中的789张切片(占比95%)作为训练集,其余样本50张为验证集。6种深度学习网络分别为语义分割网络U-Net、DANet、UA-Net,实例分割网络Mask R-CNN、Mask R-CNN FPN以及Mask R-CNN RX FPN进行建筑提取方法对比研究。

表1 不同模型比较的参数设置

Table 1

| 语义分割模型 | 实例分割模型 | ||

|---|---|---|---|

| 训练参数 | 参数值 | 训练参数 | 参数值 |

| 初始学习率 | 0.001 | 初始学习率 | 0.001 |

| 优化器 | Adam | 优化器 | Adam |

| 损失函数 | binary cross entropy | 损失函数 | 分类损失、检测损失和掩膜分割损失之和 |

| 批尺寸 | 10 | 批尺寸 | 10 |

| 时期 | 20 | 时期 | 20 |

4 结果与分析

4.1 多模型精度评价

利用模型评价参数对2类(6种)深度学习模型的验证结果开展模型的精度评价。由表2可知,在当前相同的工作环境(样本量、高分影像精度等),语义分割模型表现了更高的精度。语义分割模型U-Net、DANet以及UA-Net的精确率分别为88.98%、81.68%、83.82%,召回率分别为87.84%、76.58%、82.01%,F1指数分别为88.09%、78.46%、82.30%,IoU分别为79.37%、65.59%、71.03%;实例分割模型Mask R-CNN、Mask R-CNN FPN、Mask R-CNN RX FPN的精确率分别为81.13%、82.71%、82.05%,召回率分别为66.73%、59.02%、64.36%,F1指数分别为72.65%、67.97%、71.35%,IoU分别为57.80%、52.53%、56.44%。总体来看,深度学习模型的整体精度随着网络复杂性增加而降低,其训练时长随着网络的复杂呈现增加趋势。也就是说,U-Net(语义分割)和Mask R-CNN(实例分割)网络本身在各自对应类型内的精度和效率表现上相对较优。

表2 不同深度学习模型精度对比

Table 2

| 骨干网络(backbone) | 精确率(Precision) | 召回率(Recall) | F1指数 | IoU | 训练时长/h | |

|---|---|---|---|---|---|---|

| U-Net | -- | 88.98% | 87.84% | 88.09% | 79.37% | 20 |

| DANet | -- | 81.68% | 76.58% | 78.46% | 65.59% | 30 |

| UA-Net | -- | 83.82% | 82.01% | 82.30% | 71.03% | 35 |

| Mask R-CNN | ResNet | 80.62% | 72.46% | 75.34% | 61.82% | 17 |

| Mask R-CNN FPN | ResNet FPN | 83.13% | 66.65% | 67.97% | 52.53% | 31 |

| Mask R-CNN RX FPN | ResNeXt FPN | 85.14% | 66.36% | 73.61% | 59.70% | 43 |

4.2 多模型提取建筑轮廓效果对比

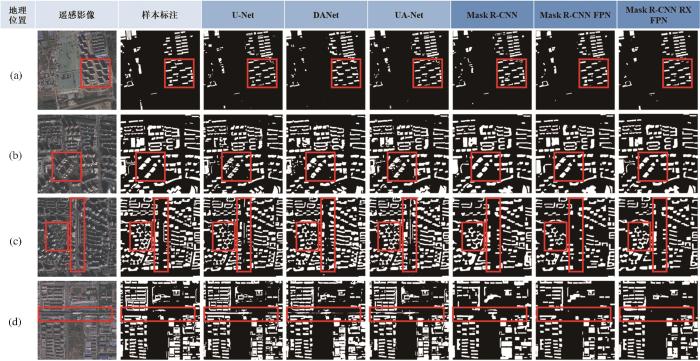

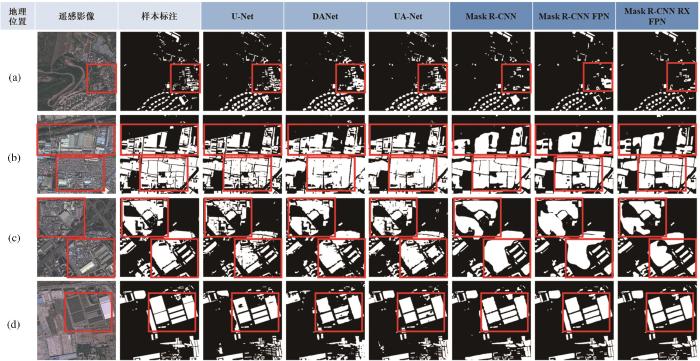

图5

图5

不同模型的城市内部建筑物轮廓提取结果对比

(a)贺村新村 (40.058267 N, 116.386069 E);(b)望京西园-三区 (40.000311 N,116.478681 E);(c)安慧里社区 (39.994333 N,116.413703 E);(d)苏庄地铁站 (39.723286 N,116.126764 E)

Fig.5

Comparison of building footprints extraction in city with different models

图6

图6

不同模型的城市周边乡村平房轮廓提取结果对比

(a)中骏绿洲庄园 (39.918202 N,116.451586 E);(b)大一村 (39.838892 N,116.595497 E);(c)宏陶居 (39.961353 N,116.398486 E);(d)河湖流域管理事务中心 (39.907803 N,116.297894 E)

Fig.6

Comparison of building footprints extraction in village with different models

为了验证模型的鲁棒性,研究对比了模型在不同建筑类型间的提取效果,如城市内部的高层及中层建筑与城市周边乡村平房区等。因为语义分割模型对具有明显的建筑间距和空间形态特征的建筑敏感性较强,U-Net模型提取的城市内部居住类建筑轮廓较为准确且建筑边缘也较完整(图5(a)、图5(b)),但对于建筑阴影仍存在部分漏分现象,特别是中低层建筑(图5(c))。虽然DANet模型的整体表现略低于U-Net, 但由于注意力机制的引入,能够弥补由于影像阴影所造成的高层建筑部分漏分现象,从而提高对模型的表现(图5(b)、图5(c))。类似的模型表现也适用于UA-Net。Mask R-CNN模型对于高层建筑群独栋建筑轮廓的提取置信度较高(图5(a)),但存在提取的建筑轮廓边缘模糊情况(图5(b)、图5(c));对于中低层建筑,这种由于边缘模糊所导致的提取效果变差显得尤为明显(图5(c))。类似的问题也见于Mask R-CNN FPN和Mask R-CNN RX FPN模型。

深度学习模型对城市内、外建筑识别表现之间的差异主要受两个因素影响。一方面,在构建训练样本库阶段是以城市建筑为主,对于农村比较密集且较小的居民点建筑缺乏精细的样本进行区分。另一方面,受影像分辨率影响,农村密集的居民点建筑本身的间隙较小(例如小于1米),在影像上视觉表现模糊,模型无法识别并提取。鉴于以上分析,研究认为基于更高分辨率的遥感数据是解决农村地区密集居民点建筑提取的发展方向。

4.3 北京市域建筑轮廓提取结果评估

基于上述分析,利用提取效果表现较好的U-Net模型对2018年北京市域遥感影像进行建筑轮廓提取,并与相同年份的测绘建筑数据成果进行对比,评估模型在北京市域的适用性及有效性。研究发现U-Net模型对于胡同、高层建筑及别墅等建筑类型均能够进行有效提取,边缘明确,与测绘建筑数据效果较为相近。根据统计,U-Net模型提取北京市建筑投影面积为1 067.3 km2,测绘建筑数据投影面积为726.4 km2,二者相交建筑投影面积为615.4 km2,即测绘建筑数据和深度学习模型识别的建筑轮廓数据均为建筑投影的面积为615.4 km2,占测绘建筑数据的84%,由此可见,U-Net模型对于测绘建筑数据有较高的召回率。虽然U-Net模型本身得到的结果存在一定程度的分类误差,其他因素也会对二者的面积差异产生一定影响。例如测绘建筑数据的阶段性更新特性使得部分地区建筑更新未能进行有效监测;测绘建筑数据对农村居民点建筑的覆盖性相对较弱;采用的遥感影像非正射投影也会增加了U-Net识别的建筑投影面积等。综上所述,U-Net模型在大范围建筑的识别结果与当前的测绘数据有较高的一致性,并且提取效率较高,为建筑的快速提取和实时监测提供了技术手段。

5 结 论

本研究基于北京2号高分遥感影像,建立了北京市典型建筑轮廓的样本库,并利用多种语义分割、实例分割模型进行建筑轮廓提取的对比,评估不同模型在城市范围内建筑识别提取的优劣。通过对比评估可以看出,在城市建筑轮廓提取中,网络层数较浅的模型在识别遥感影像中的建筑颜色、纹理、边缘等特征有明显优势。整体而言,语义分割模型在本实验中相比于实例分割模型更具优势,特别是模型应用于不同类型建筑的泛化性和鲁棒性。例如,语义分割模型提取的建筑边缘表征上更加清晰。

基于对不同类型深度学习模型的对比,研究选择了在当前样本情况下,精度表现较高的语义分割模型U-Net对北京市建筑轮廓进行提取,形成了一套精度较高的北京市建筑轮廓数据,为大范围城市建筑轮廓的高效快速提取与深度学习模型提取不同类型建筑研究提供了可靠的技术方案。

利用深度学习模型对高分遥感影像进行建筑轮廓提取,可以满足地图制图和地理信息系统对建筑物轮廓数据采集和自动更新的需求。本研究对不同种类、不同模型提取不同类型建筑的精度进行评估,这有利于在不同建筑提取任务中高效地选择更有针对性的模型,有利于遥感影像在城市规划、智慧城市建设等领域的深入应用和扩展, 对遥感影像制图、城市变化监测、三维建模、地理信息系统的数据获取、城市空间数据库的更新等建设“数字化城市”领域具有重要的应用价值。

参考文献

Bulletin of the Seventh National Population Census (No. 7) - Urban and Rural Population and Floating Population Situation

[EB/OL], ,

Organic regeneration and elaborated urban management

[J].

城市有机更新与精细化管理

[J].

Oriented to fine management of urban building height guidance——Urban design practice of building height and skyline in the old town of Huairou New Town in Beijing

[J].

面向精细化管理的城市建筑高度引导——北京怀柔新城老城区建筑高度及天际线城市设计实践

[J].

Central district urban design for detailed management in new institutional environment: Zhongguancun area, Beijing Case

[J].

新制度环境下对接精细化管理的重点地区城市设计—以北京中关村大街地区城市设计为例

[J].

Research and practice of urban fine design management——Take Beijing Mentougou New Town and Fangshan New Town urban design pilot work for example

[J].

城市精细化设计管理研究及实践——以北京门头沟新城及房山新城城市设计试点工作为例

[J].

Research on methods of building extraction from high resolution remote sensing images

[J].

高空间分辨率遥感影像建筑物提取方法综述

[J].

Building change detection from multitemporal high-resolution remotely sensed images based on a morphological building index

[J].

Automated detection of arbitrarily shaped buildings in complex environments from monocular vhr optical satellite imagery

[J].

Object-based features for house detection from rgb high-resolution images

[J].

High resolution remote sensing image building extraction in dense urban areas

[J].

密集城区高分辨率遥感影像建筑物提取

[J].

A new building extraction postprocessing framework for high-spatial-resolution remote-sensing imagery

[J].

Automatic extraction of buildings from UAV-based imagery using Artificial Neural Networks

[J].

Deep learning

[J].

Deep learning earth observation classification using imagenet pretrained networks

[J].

Simultaneous detection and segmentation

[C]∥

A method for building extraction by fusing feature information from LiDAR data and high-resolution imagery

[J].

融合LiDAR数据与高分影像特征信息的建筑物提取方法

[J].

Rural construction land extraction from high spatial resolution remote sensing image based on SegNet semantic segmentation model

[J].

基于SegNet语义模型的高分辨率遥感影像农村建设用地提取

[J].

Research on small building extraction method in small dataset

[J].

小数据集中的小型建筑物提取方法研究

[J].

Building detection from remote sensing images based on improved U-net

[J].

基于改进U-net的遥感影像建筑物提取

[J].

Building extraction based on Unet with an attention block and multiple losses

[J].

Buildings egmentation of remote sensing images based on VGG16 pre-encoding

[J].

基于VGG16预编码的遥感图像建筑物语义分割

[J].

Urban building extraction by combining multiple image features and CNN

[J].

结合多种影像特征与CNN的城市建筑物提取

[J].

Remote sensing image segmentation using dual attention mechanism Deeplabv3+algorithm

[J].

采用双注意力机制Deeplabv3+算法的遥感影像语义分割

[J].

The application of deep convolution neural network to building extraction in remote sensing images

[J].

High-resolution image building extraction using U-net Neural Network

[J].

利用U-net网络的高分遥感影像建筑提取方法

[J].

Typical element extraction method of remote sensing image based on Deeplabv3 + and CRF

[J].

基于Deeplabv3+与CRF的遥感影像典型要素提取方法

[J].

Remote sensing building detection based on binarized semantic segmentation

[J].

基于二值语义分割网络的遥感建筑物检测

[J].

Instance segmentation of indoor scenes using a coverage loss

[C]∥

U-Net-Id, an instance segmentation model for building extraction from satellite images—Case study in the Joanópolis City, Brazil

[J].

Instance segmentation of buildings from high-resolution remote sensing images with Multitask Learning

[J].

基于多任务学习的高分辨率遥感影像建筑实例分割

[J].

Research on object recognition method of urban buildings in high spatial resolution remote sensing imagery

[D].

高分遥感城市建筑物对象化识别方法研究

[D].

Multi-target detection and segmentation of remote sensing images based on improved Mask RCNN

[J].

改进Mask R-CNN的遥感图像多目标检测与分割

[J].

Automatic extraction of buildings based on instance segmentation model

[J].

基于实例分割模型的建筑物自动提取

[J].

U-net: Convolutional networks for biomedical image segmentation

[C]∥

Dual attention network for scene segmentation

[C]∥

Mask R-CNN

[C]∥

Deep residual learning for image recognition

[C]∥

Aggregated residual transformations for deep neural networks

[C]∥

Feature pyramid networks for object detection

[C]∥

Faster R-CNN:Towards real-time object detection with region proposal networks

[J].