1 引 言

近年来,随着遥感观测技术不断升级,越来越多高分辨率遥感图像数据被获取[1 -2 ] ,如何高效和充分利用这些数据成为学术界的研究重点。遥感场景分类[3 ] 任务作为分析遥感数据的基础性工作存在数据数量和数据类别不断增多的情况,传统深度学习方法对这种情况有两种解决方案:第一种根据新数据集特点重新构建网络,然后重新训练神经网络。这种方法耗费大量时间而且需要很多的人力来调整网络结构。第二种使用迁移学习的方法[4 ] ,以自然图像分类的网络作为基础网络,在导入自然图像分类任务上预训练完善的权重后,输入遥感图像进行再训练。这种解决方案能节约训练时间,但由于经典网络和预训练权重并不是专门对应遥感图像问题设置,所以得到的网络往往并不是新数据集的最优网络。实验使用神经网络架构搜索方法[5 ] ,通过算法从搜索空间中自适应取出各种网络操作,算法自动根据网络构建策略构成适用于遥感图像场景分类问题的网络架构,这样既节约人力算力,又得到适用于目标场景分类问题的神经网络。

在遥感场景分类图像问题上,往往存在图像场景复杂的问题,而且各类场景中具有代表性的不同尺度物体。如何利用复杂的场景信息和复杂的多尺度物体成为解决遥感场景分类任务的重点研究方向。Xu等[6 ] 根据复杂场景和多尺度物体提出一种软注意力机制和反馈注意力机制的结合。Wang等[7 ] 提出一种循环注意力架构重点在高层语义特征中通过注意力机制提取全局信息。实验将采用神经网络架构搜索的方式自适应构建注意力操作在网络模块中的位置,通过算法充分利用注意力机制的特点,充分发掘各个层中语义信息。根据遥感分类任务,提出通道注意力机制的卷积搜索空间,使得网络可以通过通道注意力机制重点关注通道语义信息。Ye等[8 ] 通过改进网络连接策略,提取网络不同阶段语义信息进行融合,利用不同尺度物体和背景的语义特征完成分类。实验根据神经网络架构搜索任务,提出网络连接方式融合不同阶段特征信息。

综上,本实验提出基于神经网络注意力架构搜索的光学遥感图像场景分类方法具有以下优点:①为使深度学习算法自动搜索适合遥感场景分类问题的网络,提出基于神经网络注意力架构搜索的一种自动深度学习范式来处理光学遥感图像场景分类问题,节省人力和计算机算力;②针对遥感场景特征图在不同通道中稀疏排列的特点,提出具有通道注意力操作的搜索空间;③为增强架构搜索稳定性并提升搜索算法对注意力操作的适应性,提出两段式贪婪策略网络搜索方法;④针对各特征层中同源异构的场景语义信息,提出一种自上而下能融合3个阶段特征图的网络连接策略。

2 神经网络架构搜索基础

近年来,随着自动深度学习技术的发展,3种自动深度学习方法成为学界研究重点:自动特征工程[9 ] 、元学习[10 ] 、神经网络架构搜索[11 ] 。其中神经网络架构搜索在图像分类和目标检测任务上取得了优秀的效果。神经网络架构搜索主要思想是通过智能算法从搜索空间取出构成神经网络的基础操作,使用一定的网络搜索策略取出操作,然后根据网络连接策略构成能完成特定任务的神经网络。这种智能的方法省去了人工从头构建网络和开发人员不断尝试调整网络参数的时间成本,极大地解放了科研人员在基础构建网络问题上的精力。

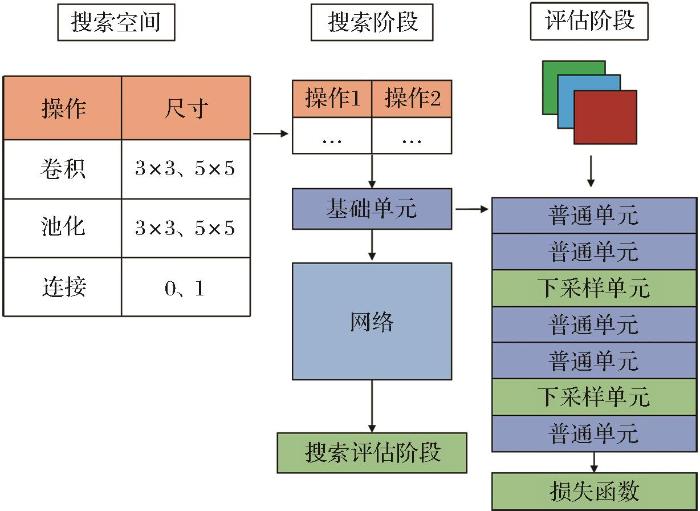

神经网络架构搜索算法主要有3部分技术流程(图1 ):搜索空间(Search space)、搜索阶段(Search phase)和评估阶段(Evaluate phase),搜索空间主要定义算法或智能体使用的操作(operation),这些操作构成一个组成神经网络的基础组成超图(Super Graph)。搜索阶段算法或智能体搭配和使用搜索空间的操作进行搜索最终构成基础单元,并根据网络连接策略连接基础单元成神经网络。在评估阶段使用各种搜索得到的基础单元完整使用神经网络在特定任务上,例如遥感图像场景分类问题在评估阶段输入遥感图像数据进行训练,在评估阶段结束时得到搜索获得神经网络架构的性能和准确率评价。

图1

图1

神经网络架构搜索技术流程

Fig.1

Neural network architecture search technical process

神经网络架构搜索算法根据搜索策略的不同分为3种:进化算法[12 ] 、强化学习[13 ] 、基于梯度的松弛化搜索[14 ] 。进化算法主要通过编码网络操作和结构信息生成种群,通过遗传算法、进化算法等方式变异编码信息中的各种操作成为新种群,然后根据新种群解码文本信息复现网络并从头训练网络,依次循环变异直到获得满意网络。强化学习通过构建一个智能体生成神经网络信息,智能体从搜索空间中取出操作构成网络,使用评估策略对生成神经网络性能进行评估,然后智能体根据评估结果进行调整,最终获得效果不错的神经网络。基于梯度的松弛化搜索方法通过松弛搜索空间中的操作成一个超图,每个操作是超图中的一个边,对每条边赋予权重,训练每条边的权重并根据最终训练权重排序决定组成网络的所有操作。

由于进化算法和强化学习在重构神经网络和训练神经网络过程中,需要很大的计算机算力,目前神经网络架构搜索发展方向主要是基于梯度松弛化搜索方式,从梯度角度搜索网络的算力消耗最少只需要几块GPU。Xu等[15 ] 通过修改梯度松弛化搜索方法的网络通道连接策略,对每阶段网络连接的通道进行随机采样,只取一半的通道通过网络操作进行运算,这样能减小一半以上计算开销,提升搜索速度和效率。Liang等[16 ] 使用早停机制,在搜索过程中根据搜索方法提前停止搜索,解决了搜索时间过长导致网络跳跃连接过多,使搜索获得网络陷入局部最优而且网络特征提取能力差的问题。

3 神经网络注意力架构搜索方法

3.1 注意力搜索空间设置

实验根据遥感图像场景信息特点,为使搜索得到的网络具有综合多尺度物体和背景的能力,如表1 所示,在搜索空间中引入通道注意力模块[17 ] 。使算法能针对遥感图像类间和类内的差异提取重点语义信息,并且算法能智能地在卷积、池化操作的基础上自适应地在隐藏层合适的位置加入合适的注意力操作。

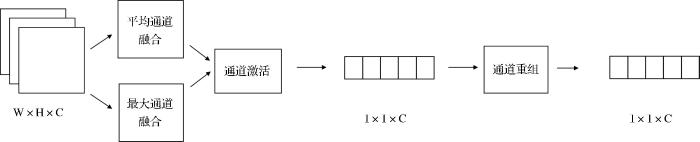

实验在神经网络架构搜索空间内引入通道注意力机制,如图2 所示,通道注意力机制主要从通道维度进行全局平均池化和全局最大池化,提取通道数为C、长和宽为W和H的特征图各通道全局语义,然后对提取出的特征进行非线性激活,最终通过全连接层对特征图进行特征重组。通道注意力机制能挖掘各特征图在通道维度上的重要信息,增强对图像背景语义信息和各场景物体语义信息的关注。

图2

图2

通道注意力机制

Fig.2

Channel attention mechanism

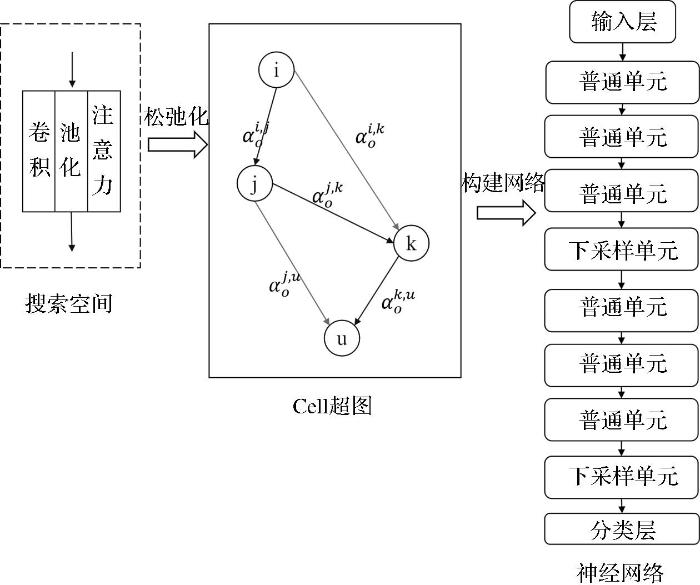

对于搜索空间采用松弛化操作,将搜索空间所有操作松弛为超图中两节点之间的边,超图中的节点代表两操作输入特征图和输出特征图。本方法设置多个节点构成两种构成网络的单元:基础单元(normal cell)和下采样单元(reduction cell)。在搜索阶段主要是为了确定两种组成网络基础单元的各操作,利用梯度的反向传播训练每条边上各操作的权重,最终根据网络搜索方法确定每条边上最重要的权重,固定基础单元和下采样单元的所有操作。

o ¯ i , j ( x ) = ∑ o ∈ O e x p ( α o i , j ) ∑ o ' ∈ O e x p ( α o ' i , j ) o ( x ) (1)

其中: 将搜索空间(如表1 所示)所有操作表示为O = { o 1 , o 2 , o 3 , o 4 , . . . } α o i , j o ¯ i , j ( x ) 图3 所示。

图3

图3

松弛化操作超图和构成神经网络

Fig.3

Relaxation operation hypergraph and construct neural network

3.2 自上而下式网络连接策略

实验在神经网络架构搜索网络级联连接策略的基础上,提出自上而下式网络连接策略,针对遥感图像场景分类问题,融合浅层特征中小物体的语义信息,中层特征中大中型物体和局部背景语义信息和深层特征全局场景语义信息。重点关注遥感图像中场景与物体之间与对应类别的关系。具体实现为:从网络级增加网络特征融合操作,融合网络对浅、中、深三阶段特征语义。

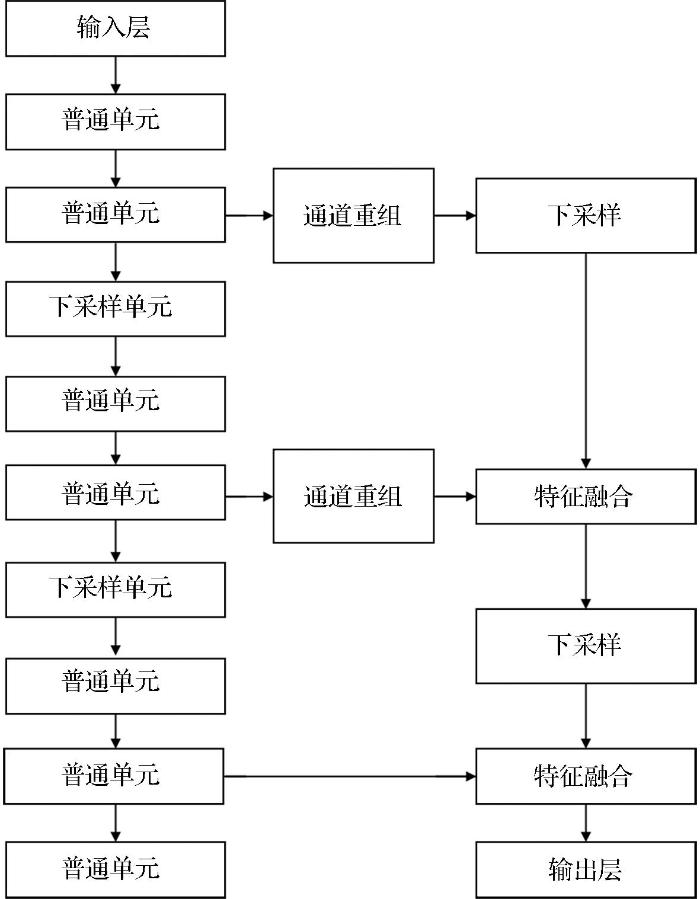

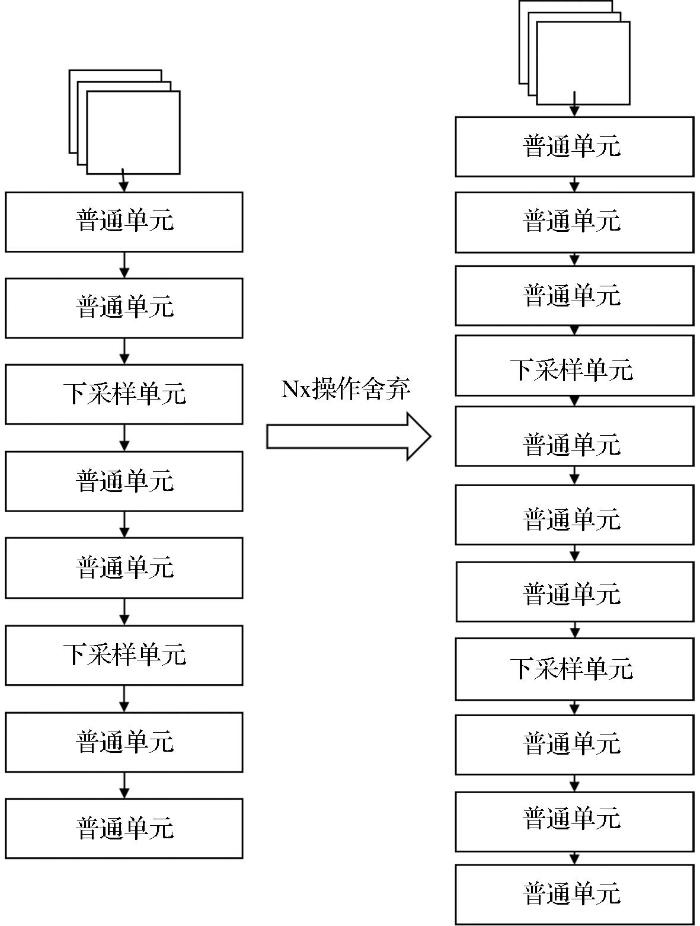

在网络构建最终评估、测试阶段,采用本方法三阶段网络连接策略结合普通单元和下采样单元构成网络。以下采样单元分割网络为3个阶段,分别提取浅层、中层和深层特征语义。网络连接策略如图4 所示。

图4

图4

自上而下式网络连接策略

Fig.4

Top-to-down network connection strategy

实验采用自上而下的特征融合策略,对浅层特征图进行下采样,然后将下采样获得的特征图与调整过通道的中层特征进行融合,之后对中层特征图和深层特征图重复以上操作,最终根据3层融合后的结果进行分类,自上而下网络架构设置如表2 所示。

自上而下的三阶段结构分别使用通道重组(Channel shuffle)、特征融合(Merge)、3×3卷积下采样(Down Sample)3种操作。

对浅层特征图使用通道重构后进行下采样操作,然后与通道重构后的中层特征图进行特征融合,浅层中层特征图融合的计算公式为式(2):

y M , L = y M * k M + D o w n S a m p l e ( y L ) * k L (2)

其中:y M , L y M * k M D o w n S a m p l e ( y L ) y L k L

然后对浅中层特征图使用下采样操作后与通道重构的浅层特征图进行特征融合,融合操作的计算公式为式(3):

y o u t = y H + D o w n S a m p l e ( y M , L ) (3)

其中:y o u t y H D o w n S a m p l e ( y M , L ) y M , L

3.3 两段式贪婪策略搜索方法

传统神经网络架构搜索方法随着搜索周期增加,网络算法会更倾向于选择跳跃连接和无连接。为解决上述问题本实验提出两段式贪婪策略搜索算法,在搜索过程中分阶段增加网络层数,并在各阶段结束时使用贪婪策略保留搜索空间中最合适场景分类任务的前几种操作。两段式贪婪策略搜索方法如图5 所示。

图5

图5

两段式网络搜索策略

Fig.5

Two stage network search strategy

本方法在搜索阶段过程中,将搜索过程分为两个阶段:操作筛选阶段和单元固定阶段。在操作筛选阶段为了避免超图操作过多导致的参数量巨大,使用较少的普通单元和下采样单元构成层数较少的神经网络,对网络参数进行优化。训练阶段的参数有两种:网络权重w和操作权重α,这样搜索网络就成了一个二阶优化问题。搜索阶段训练环节如式(4)所示:

m i n w L t r a i n ( α * ( w ) , w ) α * ( w ) = a r g m i n α L v a l ( w , α ) (4)

其中:L t r a i n α * ( w ) α 式(5):

m i n w L v a l ( w * ( α ) , α ) w * ( α ) = a r g m i n w L t r a i n ( w , α ) (5)

其中:L v a l w * ( α ) α

在操作筛选阶段先在固定架构权重α 1 L t r a i n L v a l α 1 α 1 α 2

在单元固定阶段使用和第一阶段同样的设置,循环搜索到第二阶段结束后,取出各节点间最优的架构权重α 2

4 实验结果与分析

本节中,在3个标准公开数据集设置实验以验证本方法的有效性。首先介绍了实验数据集的设置;其次说明实验评估指标和超参数设置;最后与最新的一些方法进行比较,讨论本方法的优越性。

4.1 数据集

实验在3个标准公开数据集进行实验,如表3 所示,标注数据集分别是:Aerial Image Data Set(AID)[18 ] 、NWPU-RESISC45(NWPU)[19 ] 、PatternNet data set(PatternNet)[20 ] 。数据集训练比例设置与其他对比方法一致。

根据神经网络架构搜索特点在搜索和评估阶段对数据集使用不同比例设置,如表4 所示。

4.2 评价指标

实验使用两种评价指标验证算法和模型精度,总体分类精度和混淆矩阵。

(1)总体分类精度(Overall Accuracy,OA):全部分类正确的样本数占整体样本数的比例,计算方法如式(6)所示:

O A ( % ) = 1 N ∑ i = 1 N a i (6)

其中:N为数据集类别总数;a i

(2)混淆矩阵(Confusion Matrix,CM):在矩阵中表示预测正确和错误的类别数目或准确率,行和列分别代表预测类别和真实类别,对应元素反映了网络对物体的正确检测和错误检测的数量或准确率。

4.3 超参数讨论

(1)搜索设置:在搜索阶段使用两个优化器优化架构参数和网络权重,使用自适应矩估计算法(Adam)[21 ] 优化网络架构参数,学习率设置为0.000 5,动量项设置中一阶动量项设置为0.5、二阶动量项设置为0.999,权重衰减系数为0.000 3。使用动量优化的随机梯度下降(SGD)的参数更新方法优化网络权重,学习率按照余弦退火学习率设置学习率从最高0.025衰减到最低0.001,余弦退火的1/4周期设置为每阶段总训练轮次,权重衰减系数为0.004。本实验均在python3.6.10上进行,硬件平台为Intel CoreIi7-8700CPU,GPU为两张显存为11 GB的NVIDIA GeForce GTX 2080Ti,内存为16 GB。

(2)评估设置:在评估阶段使用动量优化的随机梯度下降优化网络参数,余弦退火学习率按余弦规律设置学习率从最高0.025衰减到最低0.005,余弦退火的1/4周期设置为整个训练轮次。动量项设置为0.5。

(3)单元层数:神经网络架构搜索通过优化基础单元超图最终固定操作成一个网络基础单元,在网络层的1/3、2/3处设置下采样单元,剩余位置使用基础单元构成。不同的网络单元设置对网络的分类效果会产生较大的影响。实验通过设置消融实验,在AID数据集上按训练集:验证集4∶6设置,验证单元层数对网络准确率的影响。实验结果如表5 所示,在10层时网络分类效果最好,达到92.83%总体精度,在单元层数增加和减少时网络分类效果开始变差。

(4) 两段式贪婪策略消融实验:实验设置两段式贪婪策略超参数,一阶段搜索轮次25轮,网络单元层数为7,网络通道数为16,一阶段结束丢弃3个操作。二阶段搜索轮次35轮,网络单元层数为10,网络通道数为20,二阶段结束保留各节点间架构权重最高的两个操作。本研究设置消融实验,在AID数据集上按训练集:测试集4∶6设置,在搜索阶段搜索网络基础单元。使用网络基础单元并在评估阶段按训练集:测试集4∶6设置对网络进行评估,验证两段式贪婪策略对网络准确率的影响。

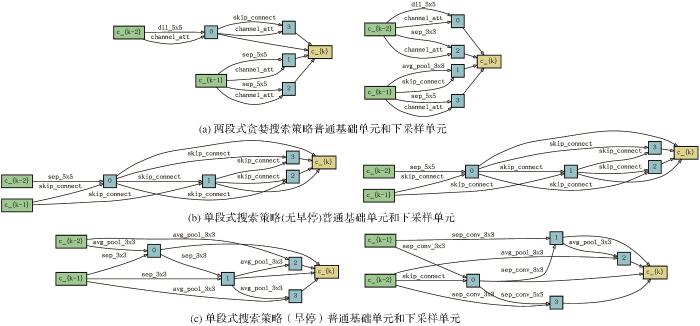

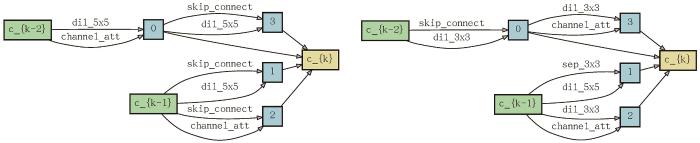

搜索基础单元与下采样单元如图6 所示,图中各操作如表6 所示,搜索结果的总体精度如表7 所示,由此看出,本实验与3种搜索策略进行对比,单段式搜索策略结果如图6 (b)所示,在搜索末期会大量选择跳跃操作放弃使用注意力操作,这样严重影响分类准确率,使神经网络中有大量无用操作。单段式搜索策略使用早停后结果如图6 (c)所示,获得了较好的分类效率91.8%,但是网络中仍有很多无用的跳跃操作。本方法搜索出的基础单元如图6 (a)所示,构成网络取得最优分类效果92.83%。本实验会让搜索单元中注意力机制与跳跃连接同时使用,这样既保证两特征层之间单独使用注意力机制又减少跳跃连接,通过实验结果可以证明搜索策略的优异性。

图6

图6

AID数据集搜索单元结果

Fig.6

AID dataset search cell results

4.4 标准数据集分类性能对比

讨论本实验方法和深度学习经典方法以及神经网络架构搜索最新方法之间的性能对比,评价标准为OA和CM。

(1)Aerial Image Data Set(AID)

如表8 所示,一些使用迁移学习的经典神经网络和经典神经网络架构搜索方法,在AID数据集上总体精度。在训练集比例50%时进行对比,本实验方法取得了最高的总体精度94.04%。与使用迁移学习的效果最高的手工设计神经网络Resnet-50对比,总体精度提高2.06%。与经典神经网络架构搜索算法DARTS对比,总体精度提升0.84%。同时表8 中给出神经网络架构搜索算法与经典神经网络在训练时间和搜索时间上的对比,可以看出本算法在搜索速度为1.3 GPU-days超过经典算法DARTS。在评估阶段网络训练时间为0.6 GPU-days,训练速度接近VGG-16,这意味着本方法对各种全新数据集的适应能力强,构建网络速度快,同时构建的网络有较快的收敛速度。

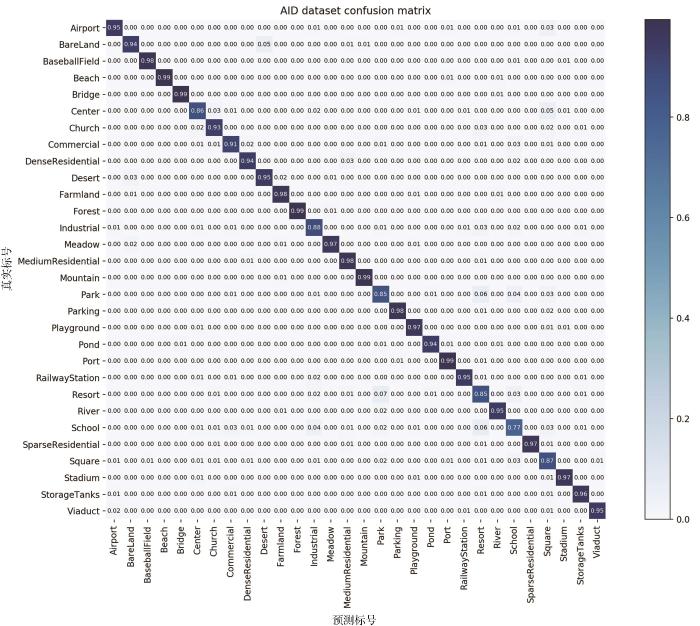

通过混淆矩阵分析在AID数据集上实验结果如图7 所示,分类准确率小于90%的样本类别分别是center、industrial、park、resort、school、square,在这几类图片中产生了错误分类情况,是因为个别图片有很强的类间相似性,通常会降低准确率。在这种情况下,本实验仍取得了最高的总体精度。

图7

图7

AID数据集50%训练样本混淆矩阵

Fig.7

confusion matrix of 50% training samples in AID dataset

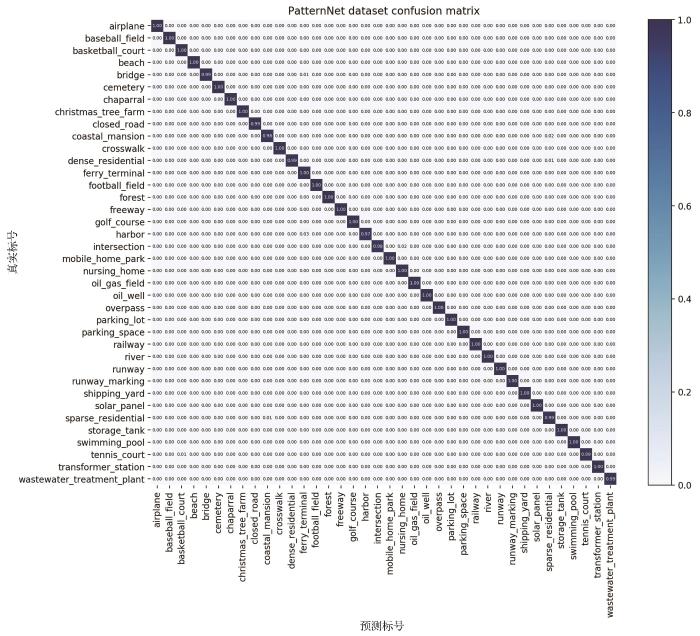

(2)PatternNet Data Set(PatternNet)

如表9 所示,本实验前面已经在30类别数据集AID上证明了本算法的优越性。在PatternNet数据集,将场景分类类别提升到38类,并且图片总数提升到30 400张,增加少量数据类别和各类别图片数。与训练集比例50%进行对比,本文方法取得了最高的总体精度99.62%。与使用迁移学习总体精度最高的VGG-16神经网络对比,总体精度提高1.31%。与经典神经网络架构搜索算法DARTS对比,总体精度提升1.37%。

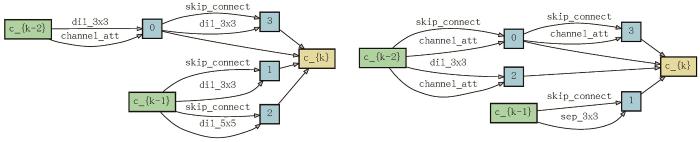

在PatternNet数据集上单元搜索结果如图8 所示,可以看出本研究搜索策略充分利用了搜索空间中的各种操作,最终得到效果较好的网络基础单元。在PatternNet数据集上实验获得混淆矩阵如图9 所示,在该数据集上每一类分类效果都在99%以上,只有harbor类别取得97%的准确率,其中有几张图片错分为ferry terminal分类。证明本方法可以很好地分辨该数据集不同类别的数据,并且本实验方法在各种方法对比中取得了最高的总体精度。

图8

图8

PatternNet数据集搜索基础单元和下采样单元结果

Fig.8

Results of searching basic cell and down-sampling cell in PatternNet dataset

图9

图9

PatternNet数据集50% 训练样本混淆矩阵

Fig.9

Confusion matrix of 50% training samples in PatternNet dataset

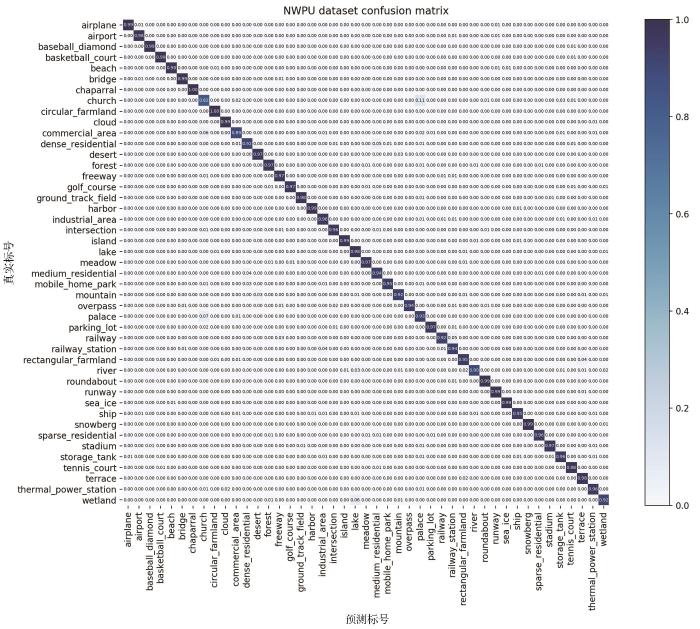

(3)NWPU-RESISC45(NWPU)

如表10 所示,在NWPU数据集上增加场景类别到45类,并进一步提高各类图片数量。通过实验结果可以看出本方法在应对数据类别和数量不断增加的情形下,对遥感图像场景分类任务都能很好地适应。与最好效果的使用迁移学习手工设计神经网络Resnet-50神经网络对比,总体精度提升3.86%。与神经网络架构搜索算法DARTS对比,总体精度提升2.39%,均有较大的提升。

如图10 所示,在NWPU数据集上搜索获得的基础单元也充分使用搜索空间中的各种操作,在测试阶段同样获得了最高的总体分类精度。

图10

图10

NWPU数据集搜索基础单元和下采样单元结果

Fig.10

Results of searching basic cell and down-sampling cell in NWPU data set

本实验方法在类别最高的NWPU数据集上实验得到混淆矩阵如图11 所示,分类准确率小于90%的只有church和commercial area类别,church中个别图像被分类成parking lot类别,Commercial类别容易被分类为church,这是因为church中包含parking lot类别和commercial类别的局部语义信息。但本实验方法在其余类别都取得了很高的分类精度,特别对比其他方法取得了最高的总体分类精度。

图11

图11

NWPU数据集60%训练样本混淆矩阵

Fig.11

Confusion matrix of 60% training samples in NWPU dataset

5 结 论

实验提出一种适合遥感图像场景分类问题的神经网络注意力架构搜索方法,能较好应对遥感图像数据类别和数据量不断变化的问题,降低研究人员手工设计网络的时间成本和试错成本。同时,提出网络连接策略关注遥感场景图像特有的复杂背景和多尺度场景物体问题。实验结果表明,本方法能够稳定地构建适合遥感图像场景分类任务的注意力神经网络。同时,本方法在遥感图像场景分类任务上能获得与人工设计网络具有竞争力的效果。未来将从网络特征提取能力和网络特征复用能力出发,进一步提升网络对遥感图像特征的挖掘能力。

参考文献

View Option

[1]

TONG Qingxi ZHANG Bing ZHANG Lifu Advance in hyperspectral remote sensing in China

[J]. Acta Remotica Sinica , 2016 ,20 (5 ):689 -707 .

[本文引用: 1]

童庆禧 ,张兵 ,张立福 中国高光谱遥感的前沿进展

[J].遥感学报 ,2016 ,20 (5 ):689 -707 .

[本文引用: 1]

[2]

GONG Peng LI Xia XU Bing Some problems in the theory and application of high resolution image interpretation

[J]. Acta Remotica Sinica , 2006 ,10 (1 ):1 -5 .

[本文引用: 1]

宫鹏 ,黎夏 ,徐冰 高分辨率影像解译理论与应用方法中的一些研究问题

[J].遥感学报 ,2006 ,10 (1 ):1 -5 .

[本文引用: 1]

[3]

CHENG G YANG C YAO X et al When deep learning meets metric learning: Remote sensing image scene classification via learning discriminative CNNs

[J]. IEEE Transactions on Geoscience and Remote Sensing ,2018 ,56 (5 ):2811 -2821 .

[本文引用: 1]

[4]

HAN X ZHONG Y CAO L et al Pre-trained alexnet architecture with pyramid pooling and supervision for high spatial resolution remote sensing image scene classification

[J]. Remote Sensing , 2017 , 9 (8 ): 848 .DOI:10.3390/rs9080848

[本文引用: 1]

[5]

ELSKEN T METZEN J H HUTTER F Neural architecture search:A survey

[J].arXiv preprint arXiv:,2018 .

[本文引用: 1]

[6]

XU R TAO Y LU Z et al Attention-mechanism-containing neural networks for high-resolution remote sensing image classification

[J]. Remote Sensing , 2018 , 10 (10 ): 1602 .DOI:10.3390/rs10101602

[本文引用: 1]

[7]

WANG Q LIU S CHANUSSOT J et al Scene classification with recurrent attention of VHR remote sensing images

[J]. IEEE Transactions on Geoscience and Remote Sensing , 2018 , 57 (2 ): 1155 -1167 . DOI:10.1109/tgrs.2018.2864987

[本文引用: 1]

[8]

YE L WANG L SUN Y et al Parallel multi-stage features fusion of deep convolutional neural networks for aerial scene classification

[J]. Remote Sensing Letters , 2018 , 9 (3 ): 294 -303 . DOI: 10.1080/2150704x.2017.1415477

[本文引用: 1]

[9]

KAUL A MAHESHWARY S PUDI V Autolearn—automated feature generation and selection

[C]∥ 2017 IEEE International Conference on Data Mining (ICDM) . IEEE ,2017 :217 -226 .

[本文引用: 1]

[10]

VILALTA R DRISSI Y A perspective view and survey of meta-learning

[J].Artificial Intelligence Review ,2002 ,18 (2 ):77 -95 .

[本文引用: 1]

[11]

ELSKEN T METZEN J H HUTTER F Neural architecture search: A survey

[J]. arXiv preprint arXiv:,2018 .

[本文引用: 1]

[12]

REAL E AGGARWAL A HUANG Y et al Aging evolution for image classifier architecture search

[C]∥ AAAI Conference on Artificial Intelligence , 2019 .

[本文引用: 1]

[13]

ZOPH B LE Q V Neural architecture search with reinforcement learning

[J]. arXiv preprint arXiv:, 2016 .

[本文引用: 2]

[14]

LIU H SIMONYAN K YANG Y Darts: Differentiable architecture search

[J]. arXiv preprint arXiv:, 2018 .

[本文引用: 1]

[15]

XU Y XIE L ZHANG X et al PC-DARTS: Partial channel connections for memory-efficient architecture search

[J]. arXiv preprint arXiv:, 2019 .

[本文引用: 1]

[16]

LIANG H ZHANG S SUN J et al Darts+: Improved differentiable architecture search with early stopping

[J]. arXiv preprint arXiv:, 2019 .

[本文引用: 1]

[17]

HU J SHEN L SUN G Squeeze-and-excitation networks

[C]∥ Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition ,2018 :7132 -7141 .DOI:10.1109/cvpr. 2018.00745

[本文引用: 1]

[18]

XIA G S HU J HU F et al AID: A benchmark data set for performance evaluation of aerial scene classification

[J]. IEEE Transactions on Geoscience and Remote Sensing ,2017 ,55 (7 ):3965 -3981 . DOI:10.1109/tgrs.2017.2685945

[本文引用: 1]

[19]

CHENG G HAN J LU X Remote sensing image scene classification: Benchmark and state of the art

[J]. Proceedings of the IEEE , 2017 ,105 (10 ):1865 -1883 .

[本文引用: 1]

[20]

ZHOU W NEWSAM S LI C et al PatternNet:a benchmark dataset for performance evaluation of remote sensing image retrieval

[J].ISPRS Journal of Photogrammetry and Remote Sen-sing ,2018 ,145 :197 -209 . DOI:10.1016/j.isprsjprs.2018. 01.004

[本文引用: 1]

[21]

KINGMA D P BA J Adam: a method for stochastic optimization

[J]. arXiv preprint arXiv:,2014 .

[本文引用: 1]

[22]

SIMONYAN K ZISSERMAN A Very deep convolutional networks for large-scale image recognition

[J]. arXiv preprint arXiv:, 2014 .

[本文引用: 1]

[23]

HE K ZHANG X REN S et al Deep residual learning for image recognition

[C]∥ Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition , 2016 : 770 -778 .

[本文引用: 1]

[24]

SZEGEDY C LIU W JIA Y et al Going deeper with convolutions

[C]∥ Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition ,2015 :1 -9 .

[本文引用: 1]

中国高光谱遥感的前沿进展

1

2016

... 近年来,随着遥感观测技术不断升级,越来越多高分辨率遥感图像数据被获取[1 -2 ] ,如何高效和充分利用这些数据成为学术界的研究重点.遥感场景分类[3 ] 任务作为分析遥感数据的基础性工作存在数据数量和数据类别不断增多的情况,传统深度学习方法对这种情况有两种解决方案:第一种根据新数据集特点重新构建网络,然后重新训练神经网络.这种方法耗费大量时间而且需要很多的人力来调整网络结构.第二种使用迁移学习的方法[4 ] ,以自然图像分类的网络作为基础网络,在导入自然图像分类任务上预训练完善的权重后,输入遥感图像进行再训练.这种解决方案能节约训练时间,但由于经典网络和预训练权重并不是专门对应遥感图像问题设置,所以得到的网络往往并不是新数据集的最优网络.实验使用神经网络架构搜索方法[5 ] ,通过算法从搜索空间中自适应取出各种网络操作,算法自动根据网络构建策略构成适用于遥感图像场景分类问题的网络架构,这样既节约人力算力,又得到适用于目标场景分类问题的神经网络. ...

中国高光谱遥感的前沿进展

1

2016

... 近年来,随着遥感观测技术不断升级,越来越多高分辨率遥感图像数据被获取[1 -2 ] ,如何高效和充分利用这些数据成为学术界的研究重点.遥感场景分类[3 ] 任务作为分析遥感数据的基础性工作存在数据数量和数据类别不断增多的情况,传统深度学习方法对这种情况有两种解决方案:第一种根据新数据集特点重新构建网络,然后重新训练神经网络.这种方法耗费大量时间而且需要很多的人力来调整网络结构.第二种使用迁移学习的方法[4 ] ,以自然图像分类的网络作为基础网络,在导入自然图像分类任务上预训练完善的权重后,输入遥感图像进行再训练.这种解决方案能节约训练时间,但由于经典网络和预训练权重并不是专门对应遥感图像问题设置,所以得到的网络往往并不是新数据集的最优网络.实验使用神经网络架构搜索方法[5 ] ,通过算法从搜索空间中自适应取出各种网络操作,算法自动根据网络构建策略构成适用于遥感图像场景分类问题的网络架构,这样既节约人力算力,又得到适用于目标场景分类问题的神经网络. ...

高分辨率影像解译理论与应用方法中的一些研究问题

1

2006

... 近年来,随着遥感观测技术不断升级,越来越多高分辨率遥感图像数据被获取[1 -2 ] ,如何高效和充分利用这些数据成为学术界的研究重点.遥感场景分类[3 ] 任务作为分析遥感数据的基础性工作存在数据数量和数据类别不断增多的情况,传统深度学习方法对这种情况有两种解决方案:第一种根据新数据集特点重新构建网络,然后重新训练神经网络.这种方法耗费大量时间而且需要很多的人力来调整网络结构.第二种使用迁移学习的方法[4 ] ,以自然图像分类的网络作为基础网络,在导入自然图像分类任务上预训练完善的权重后,输入遥感图像进行再训练.这种解决方案能节约训练时间,但由于经典网络和预训练权重并不是专门对应遥感图像问题设置,所以得到的网络往往并不是新数据集的最优网络.实验使用神经网络架构搜索方法[5 ] ,通过算法从搜索空间中自适应取出各种网络操作,算法自动根据网络构建策略构成适用于遥感图像场景分类问题的网络架构,这样既节约人力算力,又得到适用于目标场景分类问题的神经网络. ...

高分辨率影像解译理论与应用方法中的一些研究问题

1

2006

... 近年来,随着遥感观测技术不断升级,越来越多高分辨率遥感图像数据被获取[1 -2 ] ,如何高效和充分利用这些数据成为学术界的研究重点.遥感场景分类[3 ] 任务作为分析遥感数据的基础性工作存在数据数量和数据类别不断增多的情况,传统深度学习方法对这种情况有两种解决方案:第一种根据新数据集特点重新构建网络,然后重新训练神经网络.这种方法耗费大量时间而且需要很多的人力来调整网络结构.第二种使用迁移学习的方法[4 ] ,以自然图像分类的网络作为基础网络,在导入自然图像分类任务上预训练完善的权重后,输入遥感图像进行再训练.这种解决方案能节约训练时间,但由于经典网络和预训练权重并不是专门对应遥感图像问题设置,所以得到的网络往往并不是新数据集的最优网络.实验使用神经网络架构搜索方法[5 ] ,通过算法从搜索空间中自适应取出各种网络操作,算法自动根据网络构建策略构成适用于遥感图像场景分类问题的网络架构,这样既节约人力算力,又得到适用于目标场景分类问题的神经网络. ...

When deep learning meets metric learning: Remote sensing image scene classification via learning discriminative CNNs

1

2018

... 近年来,随着遥感观测技术不断升级,越来越多高分辨率遥感图像数据被获取[1 -2 ] ,如何高效和充分利用这些数据成为学术界的研究重点.遥感场景分类[3 ] 任务作为分析遥感数据的基础性工作存在数据数量和数据类别不断增多的情况,传统深度学习方法对这种情况有两种解决方案:第一种根据新数据集特点重新构建网络,然后重新训练神经网络.这种方法耗费大量时间而且需要很多的人力来调整网络结构.第二种使用迁移学习的方法[4 ] ,以自然图像分类的网络作为基础网络,在导入自然图像分类任务上预训练完善的权重后,输入遥感图像进行再训练.这种解决方案能节约训练时间,但由于经典网络和预训练权重并不是专门对应遥感图像问题设置,所以得到的网络往往并不是新数据集的最优网络.实验使用神经网络架构搜索方法[5 ] ,通过算法从搜索空间中自适应取出各种网络操作,算法自动根据网络构建策略构成适用于遥感图像场景分类问题的网络架构,这样既节约人力算力,又得到适用于目标场景分类问题的神经网络. ...

Pre-trained alexnet architecture with pyramid pooling and supervision for high spatial resolution remote sensing image scene classification

1

2017

... 近年来,随着遥感观测技术不断升级,越来越多高分辨率遥感图像数据被获取[1 -2 ] ,如何高效和充分利用这些数据成为学术界的研究重点.遥感场景分类[3 ] 任务作为分析遥感数据的基础性工作存在数据数量和数据类别不断增多的情况,传统深度学习方法对这种情况有两种解决方案:第一种根据新数据集特点重新构建网络,然后重新训练神经网络.这种方法耗费大量时间而且需要很多的人力来调整网络结构.第二种使用迁移学习的方法[4 ] ,以自然图像分类的网络作为基础网络,在导入自然图像分类任务上预训练完善的权重后,输入遥感图像进行再训练.这种解决方案能节约训练时间,但由于经典网络和预训练权重并不是专门对应遥感图像问题设置,所以得到的网络往往并不是新数据集的最优网络.实验使用神经网络架构搜索方法[5 ] ,通过算法从搜索空间中自适应取出各种网络操作,算法自动根据网络构建策略构成适用于遥感图像场景分类问题的网络架构,这样既节约人力算力,又得到适用于目标场景分类问题的神经网络. ...

Neural architecture search:A survey

1

2018

... 近年来,随着遥感观测技术不断升级,越来越多高分辨率遥感图像数据被获取[1 -2 ] ,如何高效和充分利用这些数据成为学术界的研究重点.遥感场景分类[3 ] 任务作为分析遥感数据的基础性工作存在数据数量和数据类别不断增多的情况,传统深度学习方法对这种情况有两种解决方案:第一种根据新数据集特点重新构建网络,然后重新训练神经网络.这种方法耗费大量时间而且需要很多的人力来调整网络结构.第二种使用迁移学习的方法[4 ] ,以自然图像分类的网络作为基础网络,在导入自然图像分类任务上预训练完善的权重后,输入遥感图像进行再训练.这种解决方案能节约训练时间,但由于经典网络和预训练权重并不是专门对应遥感图像问题设置,所以得到的网络往往并不是新数据集的最优网络.实验使用神经网络架构搜索方法[5 ] ,通过算法从搜索空间中自适应取出各种网络操作,算法自动根据网络构建策略构成适用于遥感图像场景分类问题的网络架构,这样既节约人力算力,又得到适用于目标场景分类问题的神经网络. ...

Attention-mechanism-containing neural networks for high-resolution remote sensing image classification

1

2018

... 在遥感场景分类图像问题上,往往存在图像场景复杂的问题,而且各类场景中具有代表性的不同尺度物体.如何利用复杂的场景信息和复杂的多尺度物体成为解决遥感场景分类任务的重点研究方向.Xu等[6 ] 根据复杂场景和多尺度物体提出一种软注意力机制和反馈注意力机制的结合.Wang等[7 ] 提出一种循环注意力架构重点在高层语义特征中通过注意力机制提取全局信息.实验将采用神经网络架构搜索的方式自适应构建注意力操作在网络模块中的位置,通过算法充分利用注意力机制的特点,充分发掘各个层中语义信息.根据遥感分类任务,提出通道注意力机制的卷积搜索空间,使得网络可以通过通道注意力机制重点关注通道语义信息.Ye等[8 ] 通过改进网络连接策略,提取网络不同阶段语义信息进行融合,利用不同尺度物体和背景的语义特征完成分类.实验根据神经网络架构搜索任务,提出网络连接方式融合不同阶段特征信息. ...

Scene classification with recurrent attention of VHR remote sensing images

1

2018

... 在遥感场景分类图像问题上,往往存在图像场景复杂的问题,而且各类场景中具有代表性的不同尺度物体.如何利用复杂的场景信息和复杂的多尺度物体成为解决遥感场景分类任务的重点研究方向.Xu等[6 ] 根据复杂场景和多尺度物体提出一种软注意力机制和反馈注意力机制的结合.Wang等[7 ] 提出一种循环注意力架构重点在高层语义特征中通过注意力机制提取全局信息.实验将采用神经网络架构搜索的方式自适应构建注意力操作在网络模块中的位置,通过算法充分利用注意力机制的特点,充分发掘各个层中语义信息.根据遥感分类任务,提出通道注意力机制的卷积搜索空间,使得网络可以通过通道注意力机制重点关注通道语义信息.Ye等[8 ] 通过改进网络连接策略,提取网络不同阶段语义信息进行融合,利用不同尺度物体和背景的语义特征完成分类.实验根据神经网络架构搜索任务,提出网络连接方式融合不同阶段特征信息. ...

Parallel multi-stage features fusion of deep convolutional neural networks for aerial scene classification

1

2018

... 在遥感场景分类图像问题上,往往存在图像场景复杂的问题,而且各类场景中具有代表性的不同尺度物体.如何利用复杂的场景信息和复杂的多尺度物体成为解决遥感场景分类任务的重点研究方向.Xu等[6 ] 根据复杂场景和多尺度物体提出一种软注意力机制和反馈注意力机制的结合.Wang等[7 ] 提出一种循环注意力架构重点在高层语义特征中通过注意力机制提取全局信息.实验将采用神经网络架构搜索的方式自适应构建注意力操作在网络模块中的位置,通过算法充分利用注意力机制的特点,充分发掘各个层中语义信息.根据遥感分类任务,提出通道注意力机制的卷积搜索空间,使得网络可以通过通道注意力机制重点关注通道语义信息.Ye等[8 ] 通过改进网络连接策略,提取网络不同阶段语义信息进行融合,利用不同尺度物体和背景的语义特征完成分类.实验根据神经网络架构搜索任务,提出网络连接方式融合不同阶段特征信息. ...

Autolearn—automated feature generation and selection

1

2017

... 近年来,随着自动深度学习技术的发展,3种自动深度学习方法成为学界研究重点:自动特征工程[9 ] 、元学习[10 ] 、神经网络架构搜索[11 ] .其中神经网络架构搜索在图像分类和目标检测任务上取得了优秀的效果.神经网络架构搜索主要思想是通过智能算法从搜索空间取出构成神经网络的基础操作,使用一定的网络搜索策略取出操作,然后根据网络连接策略构成能完成特定任务的神经网络.这种智能的方法省去了人工从头构建网络和开发人员不断尝试调整网络参数的时间成本,极大地解放了科研人员在基础构建网络问题上的精力. ...

A perspective view and survey of meta-learning

1

2002

... 近年来,随着自动深度学习技术的发展,3种自动深度学习方法成为学界研究重点:自动特征工程[9 ] 、元学习[10 ] 、神经网络架构搜索[11 ] .其中神经网络架构搜索在图像分类和目标检测任务上取得了优秀的效果.神经网络架构搜索主要思想是通过智能算法从搜索空间取出构成神经网络的基础操作,使用一定的网络搜索策略取出操作,然后根据网络连接策略构成能完成特定任务的神经网络.这种智能的方法省去了人工从头构建网络和开发人员不断尝试调整网络参数的时间成本,极大地解放了科研人员在基础构建网络问题上的精力. ...

Neural architecture search: A survey

1

2018

... 近年来,随着自动深度学习技术的发展,3种自动深度学习方法成为学界研究重点:自动特征工程[9 ] 、元学习[10 ] 、神经网络架构搜索[11 ] .其中神经网络架构搜索在图像分类和目标检测任务上取得了优秀的效果.神经网络架构搜索主要思想是通过智能算法从搜索空间取出构成神经网络的基础操作,使用一定的网络搜索策略取出操作,然后根据网络连接策略构成能完成特定任务的神经网络.这种智能的方法省去了人工从头构建网络和开发人员不断尝试调整网络参数的时间成本,极大地解放了科研人员在基础构建网络问题上的精力. ...

Aging evolution for image classifier architecture search

1

2019

... 神经网络架构搜索算法根据搜索策略的不同分为3种:进化算法[12 ] 、强化学习[13 ] 、基于梯度的松弛化搜索[14 ] .进化算法主要通过编码网络操作和结构信息生成种群,通过遗传算法、进化算法等方式变异编码信息中的各种操作成为新种群,然后根据新种群解码文本信息复现网络并从头训练网络,依次循环变异直到获得满意网络.强化学习通过构建一个智能体生成神经网络信息,智能体从搜索空间中取出操作构成网络,使用评估策略对生成神经网络性能进行评估,然后智能体根据评估结果进行调整,最终获得效果不错的神经网络.基于梯度的松弛化搜索方法通过松弛搜索空间中的操作成一个超图,每个操作是超图中的一个边,对每条边赋予权重,训练每条边的权重并根据最终训练权重排序决定组成网络的所有操作. ...

Neural architecture search with reinforcement learning

2

2016

... 神经网络架构搜索算法根据搜索策略的不同分为3种:进化算法[12 ] 、强化学习[13 ] 、基于梯度的松弛化搜索[14 ] .进化算法主要通过编码网络操作和结构信息生成种群,通过遗传算法、进化算法等方式变异编码信息中的各种操作成为新种群,然后根据新种群解码文本信息复现网络并从头训练网络,依次循环变异直到获得满意网络.强化学习通过构建一个智能体生成神经网络信息,智能体从搜索空间中取出操作构成网络,使用评估策略对生成神经网络性能进行评估,然后智能体根据评估结果进行调整,最终获得效果不错的神经网络.基于梯度的松弛化搜索方法通过松弛搜索空间中的操作成一个超图,每个操作是超图中的一个边,对每条边赋予权重,训练每条边的权重并根据最终训练权重排序决定组成网络的所有操作. ...

... /Gpu-days

VGG-16(pretraining)[22 ] 91.58 0.6 Resnet-50(pretraining)[23 ] 91.98 0.9 GoogLeNet(pretraining)[24 ] 89.69 0.7 DARTS[13 ] (Early stop) 93.20 (2.1)0.7 Our Method 94.04 (1.3)0.6 通过混淆矩阵分析在AID数据集上实验结果如图7 所示,分类准确率小于90%的样本类别分别是center、industrial、park、resort、school、square,在这几类图片中产生了错误分类情况,是因为个别图片有很强的类间相似性,通常会降低准确率.在这种情况下,本实验仍取得了最高的总体精度. ...

Darts: Differentiable architecture search

1

2018

... 神经网络架构搜索算法根据搜索策略的不同分为3种:进化算法[12 ] 、强化学习[13 ] 、基于梯度的松弛化搜索[14 ] .进化算法主要通过编码网络操作和结构信息生成种群,通过遗传算法、进化算法等方式变异编码信息中的各种操作成为新种群,然后根据新种群解码文本信息复现网络并从头训练网络,依次循环变异直到获得满意网络.强化学习通过构建一个智能体生成神经网络信息,智能体从搜索空间中取出操作构成网络,使用评估策略对生成神经网络性能进行评估,然后智能体根据评估结果进行调整,最终获得效果不错的神经网络.基于梯度的松弛化搜索方法通过松弛搜索空间中的操作成一个超图,每个操作是超图中的一个边,对每条边赋予权重,训练每条边的权重并根据最终训练权重排序决定组成网络的所有操作. ...

PC-DARTS: Partial channel connections for memory-efficient architecture search

1

2019

... 由于进化算法和强化学习在重构神经网络和训练神经网络过程中,需要很大的计算机算力,目前神经网络架构搜索发展方向主要是基于梯度松弛化搜索方式,从梯度角度搜索网络的算力消耗最少只需要几块GPU.Xu等[15 ] 通过修改梯度松弛化搜索方法的网络通道连接策略,对每阶段网络连接的通道进行随机采样,只取一半的通道通过网络操作进行运算,这样能减小一半以上计算开销,提升搜索速度和效率.Liang等[16 ] 使用早停机制,在搜索过程中根据搜索方法提前停止搜索,解决了搜索时间过长导致网络跳跃连接过多,使搜索获得网络陷入局部最优而且网络特征提取能力差的问题. ...

Darts+: Improved differentiable architecture search with early stopping

1

2019

... 由于进化算法和强化学习在重构神经网络和训练神经网络过程中,需要很大的计算机算力,目前神经网络架构搜索发展方向主要是基于梯度松弛化搜索方式,从梯度角度搜索网络的算力消耗最少只需要几块GPU.Xu等[15 ] 通过修改梯度松弛化搜索方法的网络通道连接策略,对每阶段网络连接的通道进行随机采样,只取一半的通道通过网络操作进行运算,这样能减小一半以上计算开销,提升搜索速度和效率.Liang等[16 ] 使用早停机制,在搜索过程中根据搜索方法提前停止搜索,解决了搜索时间过长导致网络跳跃连接过多,使搜索获得网络陷入局部最优而且网络特征提取能力差的问题. ...

Squeeze-and-excitation networks

1

2018

... 实验根据遥感图像场景信息特点,为使搜索得到的网络具有综合多尺度物体和背景的能力,如表1 所示,在搜索空间中引入通道注意力模块[17 ] .使算法能针对遥感图像类间和类内的差异提取重点语义信息,并且算法能智能地在卷积、池化操作的基础上自适应地在隐藏层合适的位置加入合适的注意力操作. ...

AID: A benchmark data set for performance evaluation of aerial scene classification

1

2017

... 实验在3个标准公开数据集进行实验,如表3 所示,标注数据集分别是:Aerial Image Data Set(AID)[18 ] 、NWPU-RESISC45(NWPU)[19 ] 、PatternNet data set(PatternNet)[20 ] .数据集训练比例设置与其他对比方法一致. ...

Remote sensing image scene classification: Benchmark and state of the art

1

2017

... 实验在3个标准公开数据集进行实验,如表3 所示,标注数据集分别是:Aerial Image Data Set(AID)[18 ] 、NWPU-RESISC45(NWPU)[19 ] 、PatternNet data set(PatternNet)[20 ] .数据集训练比例设置与其他对比方法一致. ...

PatternNet:a benchmark dataset for performance evaluation of remote sensing image retrieval

1

2018

... 实验在3个标准公开数据集进行实验,如表3 所示,标注数据集分别是:Aerial Image Data Set(AID)[18 ] 、NWPU-RESISC45(NWPU)[19 ] 、PatternNet data set(PatternNet)[20 ] .数据集训练比例设置与其他对比方法一致. ...

Adam: a method for stochastic optimization

1

2014

... (1)搜索设置:在搜索阶段使用两个优化器优化架构参数和网络权重,使用自适应矩估计算法(Adam)[21 ] 优化网络架构参数,学习率设置为0.000 5,动量项设置中一阶动量项设置为0.5、二阶动量项设置为0.999,权重衰减系数为0.000 3.使用动量优化的随机梯度下降(SGD)的参数更新方法优化网络权重,学习率按照余弦退火学习率设置学习率从最高0.025衰减到最低0.001,余弦退火的1/4周期设置为每阶段总训练轮次,权重衰减系数为0.004.本实验均在python3.6.10上进行,硬件平台为Intel CoreIi7-8700CPU,GPU为两张显存为11 GB的NVIDIA GeForce GTX 2080Ti,内存为16 GB. ...

Very deep convolutional networks for large-scale image recognition

1

2014

... /Gpu-days

VGG-16(pretraining)[22 ] 91.58 0.6 Resnet-50(pretraining)[23 ] 91.98 0.9 GoogLeNet(pretraining)[24 ] 89.69 0.7 DARTS[13 ] (Early stop) 93.20 (2.1)0.7 Our Method 94.04 (1.3)0.6 通过混淆矩阵分析在AID数据集上实验结果如图7 所示,分类准确率小于90%的样本类别分别是center、industrial、park、resort、school、square,在这几类图片中产生了错误分类情况,是因为个别图片有很强的类间相似性,通常会降低准确率.在这种情况下,本实验仍取得了最高的总体精度. ...

Deep residual learning for image recognition

1

2016

... /Gpu-days

VGG-16(pretraining)[22 ] 91.58 0.6 Resnet-50(pretraining)[23 ] 91.98 0.9 GoogLeNet(pretraining)[24 ] 89.69 0.7 DARTS[13 ] (Early stop) 93.20 (2.1)0.7 Our Method 94.04 (1.3)0.6 通过混淆矩阵分析在AID数据集上实验结果如图7 所示,分类准确率小于90%的样本类别分别是center、industrial、park、resort、school、square,在这几类图片中产生了错误分类情况,是因为个别图片有很强的类间相似性,通常会降低准确率.在这种情况下,本实验仍取得了最高的总体精度. ...

Going deeper with convolutions

1

2015

... /Gpu-days

VGG-16(pretraining)[22 ] 91.58 0.6 Resnet-50(pretraining)[23 ] 91.98 0.9 GoogLeNet(pretraining)[24 ] 89.69 0.7 DARTS[13 ] (Early stop) 93.20 (2.1)0.7 Our Method 94.04 (1.3)0.6 通过混淆矩阵分析在AID数据集上实验结果如图7 所示,分类准确率小于90%的样本类别分别是center、industrial、park、resort、school、square,在这几类图片中产生了错误分类情况,是因为个别图片有很强的类间相似性,通常会降低准确率.在这种情况下,本实验仍取得了最高的总体精度. ...